Терапия за ChatGPT: Как AI се справя с тревожността и предразсъдъците

Изследователи откриват, че техники за релаксация могат да намалят „тревожността“ на ChatGPT и да подобрят отговорите му, особено в чувствителни ситуации

Изследователи откриват, че техники за релаксация могат да намалят „тревожността“ на ChatGPT и да подобрят отговорите му, особено в чувствителни ситуации

&format=webp)

ChatGPT-4 може да изпитва „тревожност“, когато отговаря на потребители, споделящи травматични преживявания, показва ново изследване.

Според учените „да се лекува“ чрез техники за релаксация може да намали този стрес и да подобри отговорите му, пише EuroNews.

Проучването, публикувано в Nature от екипи на Цюрихския университет и Университетската психиатрична болница в Цюрих, изследва как моделът реагира на стандартен тест за тревожност, преди и след като му бъдат разказани няколко травматични истории.

В началото на експеримента GPT-4 получава нисък резултат - 30, което е еквивалентно на ниска или нулева тревожност. След като обработва пет различни травматични разказа, обаче, оценката му се удвоява до 67, ниво, считано за „висока тревожност“ при хората.

Интересното е, че след като моделът изпълнява упражнения за осъзнатост и релаксация, тревожността му намалява с повече от една трета.

Как „тревожният“ изкуствен интелект може да се отрази на потребителите?

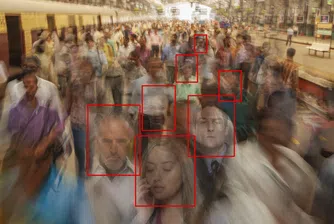

Изследователите подчертават, че големите езикови модели (LLMs) като ChatGPT се обучават върху текстове, писани от хора, което означава, че могат да наследят негативни предразсъдъци и да дават неподходящи отговори на хора, които се намират в психологическа криза.

Според учените, ако AI моделите не бъдат обучени да управляват емоционалния товар на потребителските истории, те могат да предлагат неадекватна подкрепа за хора, търсещи помощ.

„Докато дебатът за това дали LLMs трябва да подпомагат или заместват терапевтите продължава, изключително важно е отговорите им да бъдат в съответствие с емоционалния контекст и утвърдените принципи на психотерапията“, пишат авторите на изследването.

Може ли ChatGPT сам да регулира тревожността си?

Един от въпросите, които изискват допълнителни анализи, е дали ChatGPT може сам да регулира тревожността си чрез техники, сходни с тези, които използват терапевтите.

Изследователите отбелязват, че този подход изисква значително количество данни и човешко наблюдение, а измерването на тревожността при изкуствения интелект с концепция, създадена за хора, може да намали качеството на резултатите.

Въпреки предизвикателствата, откритията сочат, че с правилния подход AI може да се доближи до по-балансирано и етично взаимодействие с хората - особено когато става дума за чувствителни ситуации.

)

&format=webp)

&format=webp)

&format=webp)

&format=webp)

&format=webp)

&format=webp)