Ще имаме ли AI зима? Въпрос на доверие и проверки

Основното притеснение, предвид самите опасения на потребителите, е способността на AI да генерира зловредно съдържание като дийпфейк

Основното притеснение, предвид самите опасения на потребителите, е способността на AI да генерира зловредно съдържание като дийпфейк

&format=webp)

Бързият напредък на изкуствения интелект изисква строги регулации и концепция как етично да бъде включена новата технология на работното място.

AI трябва да играе ролята на втори пилот заедно с хората, а не да съществува на автопилот, заяви Паула Голдман, главен директор по етично и хуманно използване на Salesforce, по време на конференцията Brainstorm AI на Fortune в Лондон.

"Нуждаем се от контрол на следващо ниво. От хора, които да могат да разбират какво се случва в системата на AI. И най-важното, трябва да проектираме продукти, които да отчитат в какво AI е добър и в какво е лош - но също и в какво хората са добри и лоши в собствените си преценки за вземане на решения.", допълни тя.

Основното притеснение на Голдман предвид самите опасения на потребителите е способността на AI да генерира зловредно съдържание като дийпфейк. Експертът предупреждава, че неетичните приложения могат да ограничат финансирането и развитието на технологията.

"Възможно е следващата зима на AI да бъде причинена от проблеми с доверието или с приемането му от хората", допълва Голдман.

Бъдещето на повишаването на производителността на AI на работното място ще се определя от обучението и готовността на хората да приемат нови технологии. За да се насърчи доверието в продуктите на изкуствен интелект – особено сред служители, които използват приложенията му, Голдман предлага серия от проверки и баланси, за да се гарантира, че AI инструментите на работното място носят повече полза, отколкото вреда.

Salesforce вече прилага такава стратегия. Софтуерният гигант е разработил продукт за сегментиране на маркетинга, който генерира подходящи демографски данни за имейл кампаниите.

Докато програмата с AI генерира списък с потенциални демографски данни за дадена кампания, задачата на човека е да избере подходящите данни, така че да не изключи съответните получатели.

По подобен начин софтуерната компания разполага с предупредителен превключвател, който се появява при генеративни модели на нейната платформа Einstein, включващи кодове, които често са свързани с раса или социално-икономически статуси.

"Все повече се насочваме към системи, които могат да откриват подобни аномалии и да насърчават и подтикват хората да ги погледнат отново", казва Голдман.

Вече има достатъчно основания за разклащане на доверието по повод пристрастия и нарушения на авторските права от изкуствения интелект.

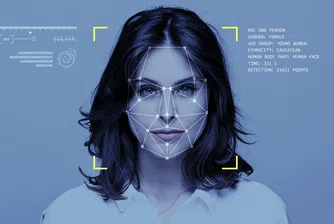

Проучване на медийната лаборатория на Масачузетския технологичен институт (MIT Media Lab) установи, че софтуерът за изкуствен интелект, програмиран да идентифицира расата и пола на различни хора, е имал по-малко от 1% грешка при идентифицирането на светлокожи мъже, но 35% грешка при идентифициране на тъмнокожи жени, включително знаменитости като Опра Уинфри и Мишел Обама.

Работните места, които използват технологията за лицево разпознаване за задачи с висок риск, като например оборудването на дронове или телесни камери със софтуер за лицево разпознаване за извършване на смъртоносни атаки, са компрометирани от неточностите в технологията за изкуствен интелект, коментира Джой Буоламвайн, автор на проучването.

По подобен начин алгоритмични пристрастия в базите данни за здравни грижи например могат да доведат до това софтуерът за изкуствен интелект да предложи неподходящи планове за лечение на определени пациенти, установиха от Йейлското училище по медицина.

Дори за кадрите в индустрии, в които не се касае за човешки живот, приложенията на изкуствения интелект предизвикват етични опасения.

OpenAI например проучва часове наред съдържание, генерирано от потребители в YouTube, като потенциално нарушава авторските права на създателите на съдържание без тяхното съгласие.

С разпространението на дезинформация и неспособността за изпълнение на основни задачи, AI трябва да извърви дълъг път, преди да реализира потенциала си като полезен инструмент за хората, допълва Голдман.

Но проектирането на по-интелигентни функции и на предпазни мерки за повишаване на доверието е това, което Голдман смята за най-вълнуващо в бъдещето на технологията.

)

&format=webp)

&format=webp)

&format=webp)

&format=webp)

&format=webp)

&format=webp)

&format=webp)