Да пуснеш гном в компютъра си: Дарио Амодей знае как се обуздава AI

„Позицията, че никога не трябва да използваме изкуствен интелект в отбраната и разузнаването, е безсмислена. Позицията, че трябва да се развихрим и правим каквото си искаме с него, е безумна“, казва основателят на водещия стартъп за AI агенти - Anthropic

„Позицията, че никога не трябва да използваме изкуствен интелект в отбраната и разузнаването, е безсмислена. Позицията, че трябва да се развихрим и правим каквото си искаме с него, е безумна“, казва основателят на водещия стартъп за AI агенти - Anthropic

&format=webp)

Дарио Амодей натрупва опита си в най-напредналите лаборатории за изкуствен интелект в света: Google, OpenAI, а сега и Anthropic.

В OpenAI ръководи основната изследователска стратегия, като изгражда нейния клас модели GPT в продължение на пет години, до 2021 г. - година преди старта на ChatGPT.

След като напуска заради различия относно бъдещето на технологията, тосновава Anthropic, AI стартъп, известен с водещия си чатбот в индустрията - Claude.

По-рано тази година Anthropic беше оценена на малко над 18 млрд. долара, а миналия месец Amazon инвестира 4 млрд. долара, с което общата сума достигна 8 млрд. долара - най-големият ангажимент на компанията в областта на рисковия капитал.

Amazon вече работи и по вграждането на моделите на Claude в следващо поколение на асистента Alexa.

Дарио Амодей, който основава Anthropic заедно със сестра си Даниела, стига до изкуствения интелект по пътя на биофизиката и е известен с това, че наблюдава т.нар. закони за мащабиране - явлението, при което софтуерът за изкуствен интелект става значително по-добър с повече данни и изчислителна мощ.

В специало интервю за Financial Times Амодей говори за новите продукти на компанията, концентрацията на власт в индустрията и основното в стратегията за изграждане на отговорен изкуствен интелект.

Рисковете и ползите от AI - голямата умора от този вечен въпрос

Разговорът започва с въпрос за неговото есе „Машини на любящата благодат“, което задълбочено описва начините, по които изкуственият интелект може да бъде полезен за обществото.

„Тази дихотомия между рисковете и ползите от AI се разиграва в света през последните 2-3 години. Никой не е по-уморен от нея колкото аз.

Що се отнася до риска... Опитах се да бъда конкретен. Що се отнася до ползите, те са силно мотивирани от технооптимизъм, нали? Ще видите постове в Twitter на разработчици, които говорят за „изграждане, изграждане, изграждане“ със снимки на зашемтяващи градове. Но наистина липсва конкретика в положителните ползи.“

Според Амодей, плюсовете от новата технология се обясняват или с много неясни, емоционални термини, или крайно.

„Можем ли действително да си представим свят, който е добър и в който хората биха искали да живеят? И кои са конкретните неща, които ще се подобрят? И какви са предизвикателствата около тях?

Ако погледнем неща като рак и болестта на Алцхаймер, в тях няма нищо магическо. Те са невероятно сложни, но изкуственият интелект е специализиран в сложността. Решението им няма да се намери изведнъж. Но - малко по малко, ще разгадаем тази сложност, с която преди не можехме да се справим.“

Амодей е убеден, че биологията и икономическото развитие са областите, които най-силно допринасят за благоденствието в човешкия живот, ето защо решава да се насочи към тях.

А на какво би посветил времето на Anthropic през 2025 г., в един идеален свят?

„Две неща: едното е механичната интерпретация, да погледнем вътре в моделите, да отворим черната кутия и да разберем какво има в тях. Това е най-вълнуващата област на изследванията в изкуствения интелект и може би най-важната за обществото.

Втората област е приложението на AI в биологията. Една от причините, поради които се насочих от биологичните науки към изкуствен интелект, е, че разгледах проблемите на биологията и те изглеждаха почти извън човешкия мащаб, почти извън човешкото разбиране - не че бяха твърде трудни от интелектуална гледна точка, но просто имаше твърде много информация, твърде много сложност.

Надявам се, подобно на някои други хора в тази област - да използвам изкуствения интелект за решаване на проблемите на науката и по-специално на биологията, за да направя човешкия живот по-добър.“

Anthropic вече работи с фармацевтични компании и биотехнологични стартъпи, но всичко е на ниво „как можем да приложим моделите на Claude точно сега?“. Надеждата е, че през 2025 г. ще започне работа по дългосрочна амбициозна версия на усилията - както с компании, така и с изследователи и учени.

AI влиза в компютъра вместо вас - и извършва операции, кликва с мишката, пише на клавиатурата…

Пет месеца след появата на Sonnet 3.5, техният последен голям модел с изкуствен интелект, Амодей отичита голяма промяна в броя на талантливите изследователи, програмисти, служители, за които подобен модел става действително полезен.

Той посочва и Artifacts: инструмент за потребителите на Claude, с който можете да се върнете назад и да кажете на модела: „Направи ми видеоигра, в която главният герой изглежда по този начин, а околната среда - по този начин“.

Но можете да се върнете, да поговорите с него и да кажете: „Не мисля, че главният герой изглежда правилно. Той прилича на Супер Марио. Искам да прилича повече на Луиджи.“ Това отново показва значението на разработката между човека и системата с изкуствен интелект.

„Въпреки че имаме потребителски продукт, по-голямата част от бизнеса на Anthropic идва от продажбата на нашия модел на други компании чрез API, върху който те изграждат тези продукти. Така че общата ни позиция в екосистемата е, че даваме възможност на други компании да създават невероятни продукти и видяхме много неща.“, допълва Амодей.

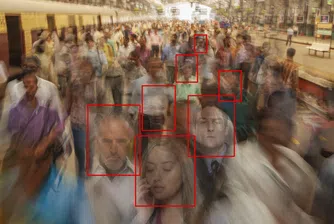

Наскоро Anthropic пуска за разработчиците възможност, наречена „Използване на компютър“. Те могат да изграждат върху нея:

„Можете да кажете: „резервирай ми този ресторант“ или „планирай пътуване за този ден“, и моделът директно ще използва вашия компютър. Той ще погледне екрана. Ще щракне с различни позиции на мишката. И ще въвежда с помощта на клавиатурата.“

Моделът не е физически робот, но е в състояние да въвежда, автоматизира и контролира компютъра вместо вас. Само няколко дни след като е пуснат, вече има версии, контролиращи екраните на iPhone и Android, Linux, Mac.

„Бихме могли да създадем продукт от типа на агент. Всъщност смятам, че най-трудното нещо при агентите с изкуствен интелект е да се уверим, че са безопасни, надеждни и предвидими.

Едно е, когато говорите с чатбот, нали? Той може да каже нещо погрешно, да обиди някого. Може да даде грешна информация. Разбира се, трябва да се отнасяме сериозно и да сме сигурни, че моделите правят точно това, което искаме от тях. Това става много по-важно, когато работим с агенти.“, допълва Амодей.

„Като мисловен експеримент, просто си представете, че имам агент и казвам: „Направете за мен проучване в интернет, формулирайте хипотеза, а след това отидете и купете материали, за да построите нещо, или направете няколко сделки предвид моята търговска стратегия.“ След като моделите правят неща в продължение на няколко часа, се отваря възможността те да правят неща, които не съм искал да правят.

Може би те ще променят настройките на компютъра ми по някакъв начин. Може би ще ме представляват, когато говорят с някого, и ще кажат нещо, което изобщо не бих одобрил. Може би ще предприемат действие на друг набор от сървъри. Може би дори ще направят нещо злонамерено.“, обяснява технологичният предприемач.

Укротяване на неизвестното

Ето защо, според него е важно непредсказуемостта да бъде укротена. Anthropic постига голям напредък в това отношение. Използват се същите методи за контрол на безопасността на обикновените системи, но нивото на предвидимост е значително по-високо.

„Става въпрос за достигането на момента, в който сме сигурни, че можем да пуснем нещо подобно с увереност и то ще прави надеждно това, което хората искат да прави; когато действително могат да имат доверие в системата. Когато стигнем тази точка, тогава ще пуснем системите.“, допълва още той.

Залогът е много по-висок, когато се преминава от това AI да ти каже нещо, което можеш да направиш, към това да направи нещо вместо теб.

„Искате ли да пуснете гном в компютъра си, който да променя произволни неща? Може никога да не разберете какво ги е променило. Но, за да бъда ясен, мисля, че всички тези проблеми са решими. Това са практическите предизвикателства, с които се сблъскваме, проектирайки подобни системи.“

Кога обаче ще стигнем точка на достатъчна предсказуемост и рутинност, за да пуснем „на свобода“ агентите?

„Това е ранен продукт. Нивото му на надеждност не е толкова високо. Не му се доверявайте за критични задачи.“, съветва Амодей и допълва:

„Мисля, че през 2025 г. ще постигнем голям напредък в тази посока. Но винаги ще има задачи, които не можете да доверите на система с изкуствен интелект, защото тя не е достатъчно умна, достатъчно автономна или достатъчно надеждна. Бих искал да стигнем до момента, в който просто ще можете да дадете на системата задача за няколко часа - подобно на тази, която бихте дали на стажант или служител.

От време на време тя се връща при вас, иска разяснения и след това изпълнява задачата. Ако искам да имам виртуален служител, който да направи цялото проучване, да напише доклад - помислете за консултант по управление или програмист - хората трябва да имат доверие, че той действително ще направи това, което са му казали, а не някакво безумно друго нещо.“

Има ли граници?

А по въпроса дали има граници на новата технология и дали се търсят алтернативни начини за увеличаване на интелигентността в тези модели, Амодей отговаря, че откакто работи в тази област през последните 10 години, спазва законите за мащабиране.

„Това, което наблюдаваме в тази област, е съвсем обичайно и се е случвало много пъти в историята. Само че, тъй като областта е по-голям проблем с повече икономически последици, повече хора й обръщат внимание сега, като свръхинтерпретират много двусмислени данни.

Ако се върнем към историята, законите за мащабиране не казват, че винаги, когато обучавате по-голям модел, той се справя по-добре. Казват, че ако мащабирате моделите, като размерът е пропорционален на данните, ако всички инженерни процеси работят добре при обучението, ако качеството на данните остава постоянно, докато го увеличавате, тогава моделите ще продължат да стават все по-добри и по-добри.“

Не сме видели нищо, което да опровергае модела, който наблюдаваме през последните няколко години, категоричен е основателят на Anthropic.

Дарио Амодей разкрива и дали компанията му използва ограничения при тренировъчните серии на настоящите AI модели.

„Тъй като естествените данни свършват, започваме да увеличаваме количеството на синтетичните данни. Така например AlphaGo Zero (версия на софтуера за игра на Го на Google DeepMind) беше обучен със синтетични данни. Съществуват и методи за разсъждение, при които учите модела да се самоанализира. Така че има редица начини да се заобиколи стената от данни.“

Огромни разходи, неясни приходи - математика на печалбата от LLM модели

Но когато говорим за мащабиране, голямото изискване е цената. Разходите се увеличават рязко. Как оцелява един стартъп като Anthropic и откъде ще дойдат тези пари през следващата година?

„Мисля, че хората продължават да разбират стойността и потенциала на тази технология.“, отговаря Амодей. Така че, съм напълно убеден, че някои от големите играчи, които ни финансират досега, както и инвестиционната екосистема, ще ни подкрепят.“

Признава, че приходите растат много бързо и е сигурен, че ниво от 10 млрд. долара - от гледна точка на разходите за моделите - е нещо, което Anthropic ще може да си позволи през следващата година. Що се отнася до рентабилността, е по-поучително да се разгледа конкретен модел.

„Нека вземем една хипотетична компания. Да кажем, че обучавате модел през 2023 г. Той струва 100 млн. долара. И след това, през 2024 г., този модел генерира, да речем, 300 млн. долара приходи. След това през 2024 г. обучавате следващ модел, който струва 1 млрд. долара. И този модел все още не е завършен или се пуска в продажба към края на 2024 г. Тогава, разбира се, той не генерира приходи до 2025 г.

Така че, ако попитате „печеливша ли е компанията през 2024 г.“, ами, спечелили сте 300 млн. долара и сте похарчили 1 млрд. долара, така че не изглежда печеливша. Ако попитате дали всеки модел е бил печеливш? Ами, моделът от 2023 г. е струвал 100 млн. долара и е генерирал няколкостотин милиона приходи. Така че моделът от 2023 г. е печелившо предложение.

Тези числа не са антропологични числа. Но това, което искам да кажа, е: разходите за моделите се увеличават, но приходите от всеки модел също се увеличават и има разминаване във времето, защото моделите се внедряват значително по-късно, отколкото се обучават.“, обяснява Амодей.

Сянката на големите играчи зад малките стартъпи

Дали обаче компания като Anthropic може да се справи без лидери като Amazon или Google зад гърба си? Според основателя на стаартъпа, сделките с големите играчи имат голям смисъл и за двете страни, тъй като инвестициите са начин да се пренесе бъдещето в настоящето. Така че, има икономически смисъл.

И все пак, не крие, че се притеснява от влиянието на тези компании, но Anthropic е много внимателна в начина, по който сключва сделките си.

„Нещата, които са важни, са например нашата политика за отговорно мащабиране, която е следната: когато възможностите на моделите достигнат определено ниво, трябва да ги измерите и да въведете предпазни мерки, ако те ще бъдат използвани.

Във всяка сделка, която някога сме сключвали, когато внедрява нашата технология, хиперсклаерът трябва да е обвързан с правилата на нашата политика за мащабиране. Няма значение на каква повърхност разгръщаме модела. Те трябва да преминат през тестовете и мониторинг за отговорно мащабиране.

Друго нещо е нашето доверие за дългосрочни ползи. Това е орган, който има надзор над Anthropic. Той има твърдата власт да назначава много от местата в борда на Anthropic. В същото време хиперскалаторите не са представени в борда. Така че крайният контрол върху компанията остава в ръцете на тръста за дългосрочни ползи, представен от финансово незаинтересовани участници с крайна власт над Anthropic.“

Неизбежно стигаме и до въпроса дали е жизнеспособно една компания, изграждаща LLM модели, да продължи да държи контрола нас продуктите си въздействието, което оказва върху хората, без да има подкрепата на Amazon, Google или Microsoft?

„Мисля, че е икономически целесъобразно да се запази контролът върху компанията. И ценностите си. Но това изисква да се осигурят големи ресурси. Може да е от хиперскалер. На теория, може да бъде от системата за рисков капитал. Може дори да е от правителството.“, отговаря Амодей.

„Виждали сме някои случаи, за добро или лошо, в които лица като Илон Мъск използват голямото си лично богатство. Смятам, че за изграждането на големи модели е необходим голям източник на капитал, но има различни възможности. И мисля, че може да го направите, като същевременно останете в съответствие с ценностите си.“

AI в отбраната и разузнаването: Искаме ли такъв свят?

Наскоро Anthropic подписа и договор с Министерството на отбраната на САЩ, но Амодей е категоричен, че това не е било решение за финансиране.

„Всеки, който създава компания, ще ви каже, че ако искате бързо да получите приходи, това е най-лошият начин. Всъщност ние го правим, защото съответства на нашите ценности. Смятам, че е много е важно демокрациите да запазят водеща позиция в тази технология и да разполагат с необходимите ресурси, за да се уверят, че не могат да бъдат доминирани или притискани от автокрации.“

Едно от опасенията му е, че макар САЩ и съюзниците им да изпреварват други държави в разработването на AI, техните противници - като Китай или Русия, може да са по-добри в използването на това, с което разполагат, за собствените им правителства.

„Не искам свят, в който изуственият интелект се използва безразборно във военната и разузнавателната среда.

Както при всяко друго внедряване на технологията - може би дори в по-голяма степен, трябва да има строги бариери за начина, по който се внедрява технологията. Нашето мнение, е, че не сме догматично против или за нещо.

Позицията, че никога не трябва да използваме изкуствен интелект в сферата на отбраната и разузнаването, за мен е безсмислена. Позицията, че трябва да се развихрим и да го използваме, за да правим каквото си поискаме - до оръжия на Страшния съд - очевидно е също толкова безумна.

Опитваме се да търсим средно положение, да правим нещата отговорно.“

В заключение, Дарио Амодей допълва, че с течение на времето ще получаваме все по-способни системи.

Убеден е, че сме на прав път и е малко вероятно да сме на повече от няколко години от общия генеративен изкуствен интелект. Ще следим развитието му непрекъснато и бързо.

)

&format=webp)

&format=webp)

&format=webp)

&format=webp)

&format=webp)

&format=webp)